A regulação da Inteligência Artificial (IA) deixou de ser um tema técnico restrito a juristas e pesquisadores. Hoje, tornou-se uma questão geopolítica, econômica e ética que impacta diretamente executivos de tecnologia, líderes de negócio e formuladores de estratégias globais. À medida que países adotam modelos distintos de regulação, compreender as diferentes abordagens é essencial para mitigar riscos, garantir conformidade e manter a competitividade.

A seguir, apresentamos os cinco principais movimentos que moldam o cenário regulatório internacional da IA, cada um com implicações práticas para CIOs, CTOs e líderes de inovação que operam em um ecossistema cada vez mais interdependente.

União Europeia: risco como eixo central da regulação

A União Europeia (UE) lidera o movimento por uma regulação abrangente com o chamado AI Act, primeira legislação estruturada de IA no mundo. O cerne da proposta é a “abordagem baseada em risco”, que classifica os sistemas de IA em quatro categorias: risco inaceitável, alto risco, risco limitado e risco mínimo.

- IAs de risco inaceitável: como pontuação social ou manipulação comportamental, serão proibidas.

- IAs de alto risco: como diagnósticos médicos assistidos, carros autônomos e reconhecimento facial, exigirão auditorias, documentação técnica, testes de conformidade e supervisão humana.

- IAs de risco limitado: como chatbots, precisarão apenas alertar os usuários sobre sua natureza automatizada.

- IAs de risco mínimo: a maioria, seguirão livres de novas exigências legais.

Essa estrutura cria um modelo de equilíbrio entre inovação e direitos fundamentais, influenciando legislações ao redor do mundo em um fenômeno conhecido como “efeito Bruxelas”.

Estados Unidos: foco na inovação com diretrizes voluntárias

Diferente da abordagem centralizada da UE, os Estados Unidos optam por uma regulação setorial, onde agências como SEC, FDA e DOT regulam a IA em seus respectivos domínios.

Em vez de leis rígidas, o país aposta no AI Risk Management Framework (AI RMF), criado pelo NIST. A estrutura não é obrigatória, mas funciona como padrão de fato para empresas que buscam governança responsável.

A filosofia americana prioriza a manutenção da competitividade e da inovação, permitindo ajustes conforme o dinamismo do mercado. No entanto, há críticas sobre a fragmentação regulatória e a falta de coerência nacional.

China: IA como extensão do controle estatal

A China adota um modelo de regulação centralizado e autoritário, com forte ligação à segurança nacional e estabilidade social. Suas regulamentações são rápidas, específicas e executadas de forma vertical.

Entre os principais marcos estão:

- As Medidas Provisórias para IA Generativa, que exigem aderência a “valores socialistas” e rotulagem de conteúdo automatizado;

- A regulação de algoritmos de recomendação, que obriga transparência e permite ao usuário optar por não receber sugestões automatizadas.

Combinadas ao sistema de crédito social, essas regras consolidam uma infraestrutura de vigilância algorítmica estatal, levantando preocupações sobre liberdade individual e privacidade.

Japão: leis brandas com foco no ser humano

O Japão opta por uma abordagem de soft law, baseada em diretrizes e princípios não vinculativos. A filosofia japonesa se apoia na IA centrada no ser humano, respeitando dignidade, transparência e responsabilidade.

As empresas são incentivadas a seguir voluntariamente os Princípios Sociais da IA e as Diretrizes de Negócios de IA, mantendo flexibilidade para responder às mudanças tecnológicas.

Contudo, essa abordagem também enfrenta críticas quanto à eficácia, especialmente diante de exigências legais mais rígidas de mercados como a UE. Por isso, discute-se uma possível evolução para uma regulação “inteligente”, combinando diretrizes com obrigações legais pontuais.

Cooperação internacional: rumo à interoperabilidade regulatória

A natureza transfronteiriça da IA impõe limites à eficácia de regulações isoladas. À medida que sistemas de IA são desenvolvidos em um país, treinados com dados de outro e utilizados globalmente, surge a necessidade de harmonizar padrões e valores regulatórios internacionais.

Diante disso, países e blocos econômicos têm buscado iniciativas de convergência normativa, como o Processo de IA de Hiroshima, coordenado pelo G7, e os Princípios da OCDE para IA, que têm ganhado relevância como base ética e funcional para legislações e diretrizes nacionais.

Princípios da OCDE: os cinco pilares de uma IA responsável

Adotados inicialmente em 2019, os Princípios da OCDE sobre Inteligência Artificial tornaram-se referência global e já foram endossados por mais de 40 países, incluindo membros da UE, Estados Unidos, Japão e Brasil. Eles estabelecem fundamentos éticos e práticos para o desenvolvimento e uso responsável da IA, influenciando políticas públicas e estruturas legais em múltiplas jurisdições.

Os cinco princípios centrais são:

1. Crescimento inclusivo, desenvolvimento sustentável e bem-estar

Sistemas de IA devem contribuir positivamente para o crescimento econômico, o progresso social e o bem-estar da humanidade. Isso significa priorizar o uso da IA em áreas que gerem impacto social positivo, como saúde, meio ambiente e educação, e evitar sua aplicação para aprofundar desigualdades ou prejuízos à dignidade humana.

2. Valores centrados no ser humano e equidade

A IA deve respeitar os direitos humanos, os valores democráticos e o Estado de Direito. Isso inclui evitar discriminação algorítmica, garantir justiça e equidade nos processos decisórios automatizados, e assegurar que as pessoas possam contestar decisões que as afetam de forma significativa.

3. Transparência e explicabilidade

Os sistemas de IA devem ser compreensíveis, auditáveis e passíveis de explicação, especialmente quando utilizados em contextos sensíveis. A capacidade de explicar como e por que uma decisão foi tomada é crucial para construir confiança e permitir a responsabilização de seus operadores.

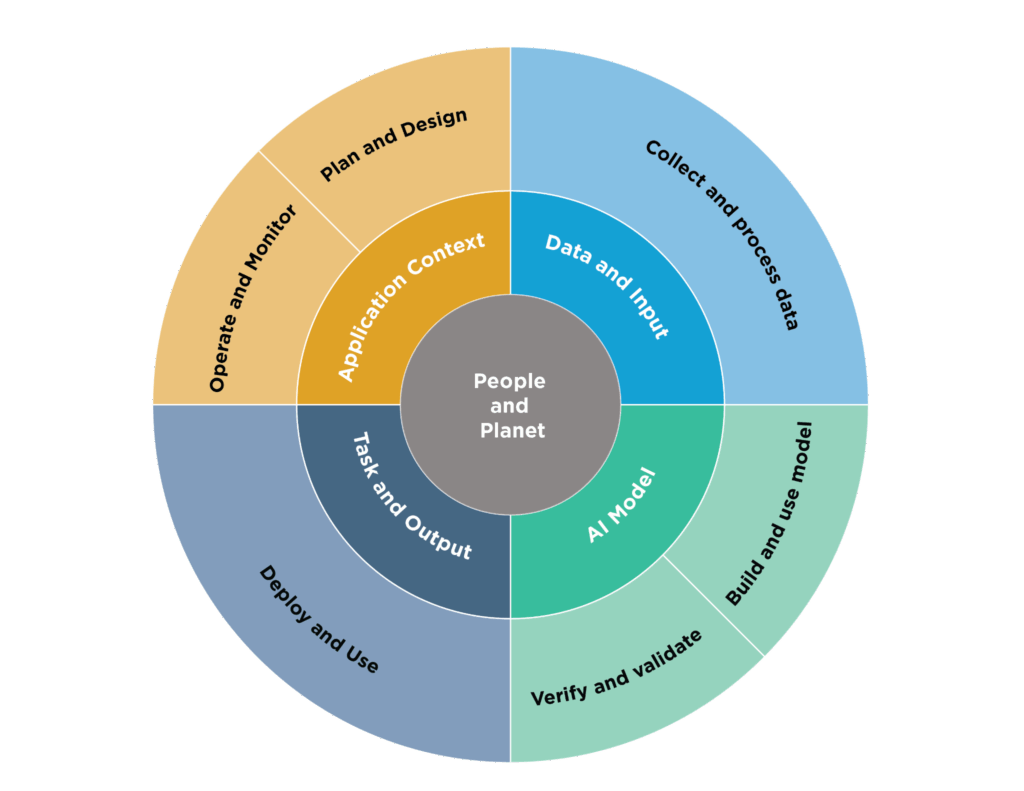

4. Robustez, segurança e proteção

As soluções de IA precisam ser tecnicamente sólidas e seguras ao longo de todo o seu ciclo de vida. Isso inclui proteção contra falhas, ataques cibernéticos, uso indevido e comportamentos inesperados. A gestão de riscos deve estar presente desde o design até a operação em ambientes reais.

5. Responsabilidade

Deve haver mecanismos claros de responsabilização para organizações e indivíduos que desenvolvem, implementam ou operam sistemas de IA. Isso envolve não apenas conformidade legal, mas também estruturas éticas internas, revisão humana contínua e canais formais para denúncias e apelações.

Interoperabilidade como objetivo estratégico

A intenção dos formuladores internacionais não é criar uma legislação única e universal, mas sim garantir que diferentes modelos regulatórios se comuniquem entre si com base nesses princípios comuns. A interoperabilidade regulatória busca equilibrar diversidade jurídica com previsibilidade operacional, permitindo que empresas multinacionais atuem com confiança jurídica em múltiplas regiões.

Esse alinhamento é fundamental para evitar fragmentação no ecossistema global de IA, reduzir custos de conformidade para empresas que operam em múltiplas jurisdições e acelerar a confiança do público no uso da tecnologia.

Siga o Itshow no LinkedIn e assine a nossa News para ficar por dentro de todas as notícias do setor de TI e Cibersegurança!